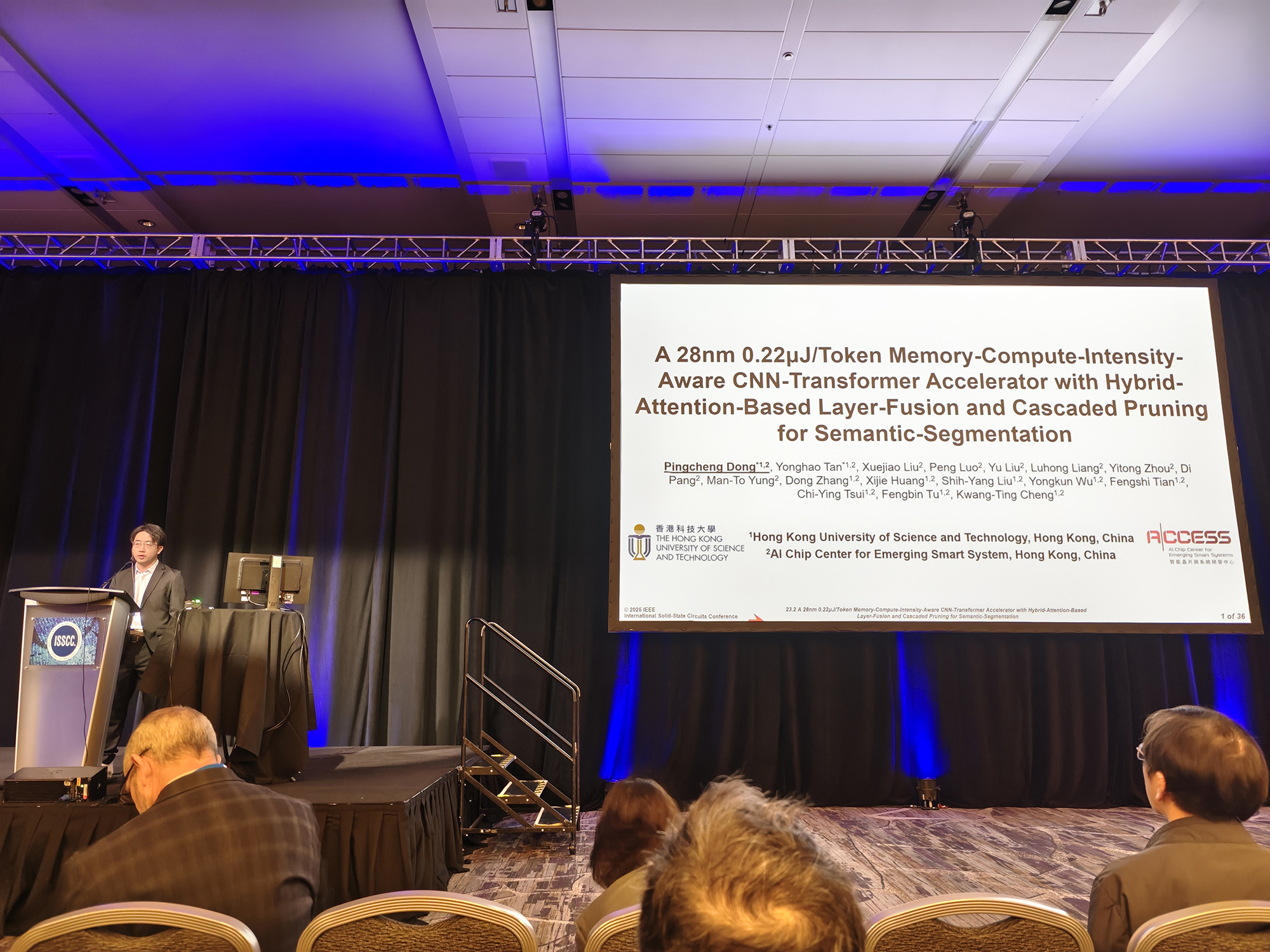

智能晶片與系統研發中心 (ACCESS) 的教授、研究生和研發團隊共同撰寫的最新研究論文《A 28nm 0.22μJ/Token Memory-Compute-Intensity-Aware CNN-Transformer Accelerator with Hybrid-Attention-Based Layer-Fusion and Cascaded Pruning for Semantic-Segmentation》近日成功在被譽為「晶片奧林匹克」的國際會議 ISSCC(國際固態電路會議)上發表。這是香港首篇發表在該頂級國際會議上的 AI 計算晶片論文,也標誌著團隊在基礎研究和設計實現方面的創新能力獲得了國際學術界的高度認可。

近年來,集成了 CNN 和 Transformer 的混合模型,在語義分割任務中取得了顯著進展,在自動駕駛和具身智慧等領域有著廣泛的應用前景;同時,針對混合模型的硬體加速器也面臨著大令牌(Token)長度和層融合導致的外部存儲訪問(EMA)激增,卷積與注意力機制稀疏計算模式的差異等等問題。為了應對這些挑戰,本篇論文提出了一種高能效的 CNN-Transformer 融合架構,包括三方面的關鍵創新點:

• 混合注意力計算引擎:結合線性注意力機制,支援高達 64K 的輸入 Token,提高計算輸送量。

• 跨層融合優化:基於秩序調度的注意力與卷積跨層融合,減少 82% 中間特徵圖的片外訪存。

• 計算模式優化:支持卷積與注意力機制的重構稀疏計算,實現 1.85 倍的加速。

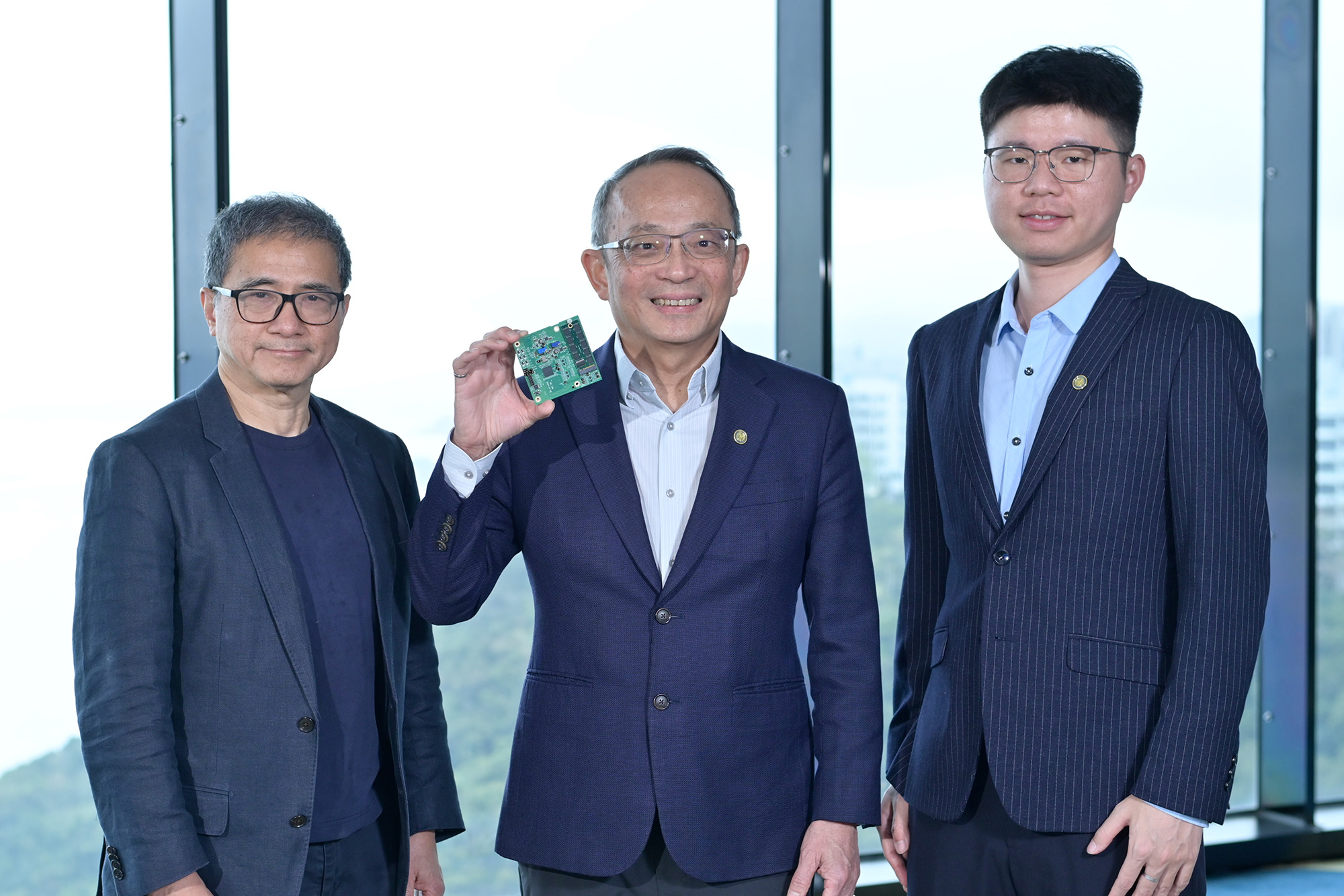

基於這些創新點,ACCESS 團隊設計並且成功流片了 28nm 的商業化實驗晶片 AC-Transformer,實現了可程式設計的 CNN 和 Transformer 模型的端到端推理。AC-Transformer 晶片在 SegFormerB0 上每個 Token 消耗 0.22μJ,與之前報導的最新成果相比,實現了3.86-10.91 倍的系統級能效提升。

ACCESS 團隊的此項研究成果在國際學術界獲得高度認可,是所有參與項目的教授、研究生、研究員和工程師的辛勤付出的結果,也是協同創新共同推動 AI 計算架構前沿探索成功範例。ACCESS 研發團隊將繼續深耕智能計算技術,探索更高效、更先進的 AI 晶片架構,為行業發展貢獻更多創新成果。