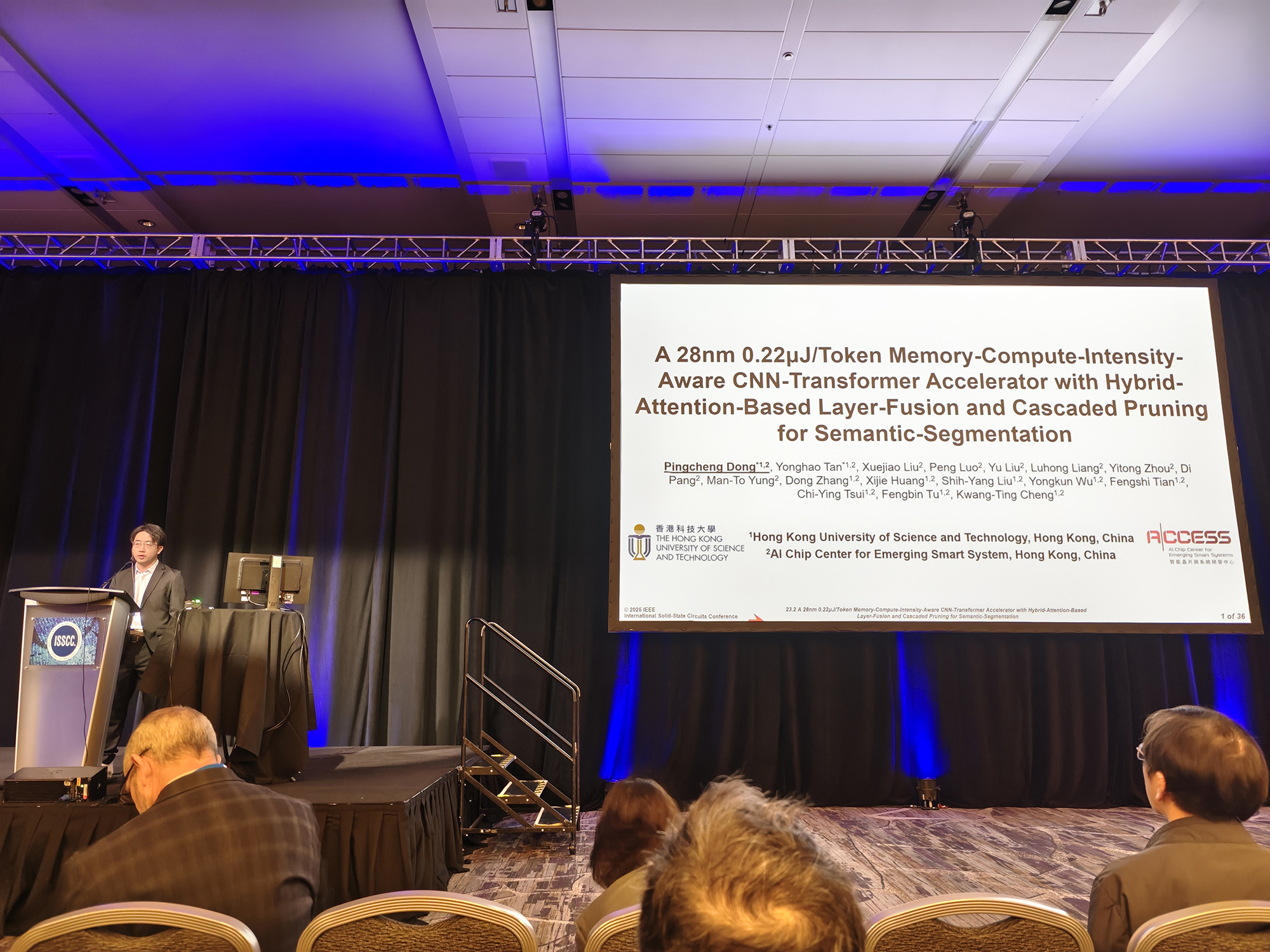

智能晶片与系统研发中心 (ACCESS) 的教授、研究生和研发团队共同撰写的最新研究论文《A 28nm 0.22μJ/Token Memory-Compute-Intensity-Aware CNN-Transformer Accelerator with Hybrid-Attention-Based Layer-Fusion and Cascaded Pruning for Semantic-Segmentation》近日成功发表在被誉为「芯片奥林匹克」的国际会议 ISSCC(国际固态电路会议)上。这是香港首篇发表在该顶级国际会议上的 AI 计算芯片论文,也标志着团队在基础研究和设计实现方面的创新能力获得了国际学术界的高度认可。

近年来,集成了 CNN 和 Transformer 的混合模型,在语义分割任务中取得了显著进展,在自动驾驶和具身智能等领域有着广泛的应用前景;同时,针对混合模型的硬件加速器也面临着大令牌(Token)长度和层融合导致的外部存储访问(EMA)激增,卷积与注意力机制稀疏计算模式的差异等等问题。为了应对这些挑战,本篇论文提出了一种高能效的 CNN-Transformer 融合架构,包括三方面的关键创新点:

• 混合注意力计算引擎:结合线性注意力机制,支持高达 64K 的输入 Token,提高计算吞吐量。

• 跨层融合优化:基于秩序调度的注意力与卷积跨层融合,减少 82% 中间特征图的片外访存。

• 计算模式优化:支持卷积与注意力机制的重构稀疏计算,实现 1.85 倍的加速。

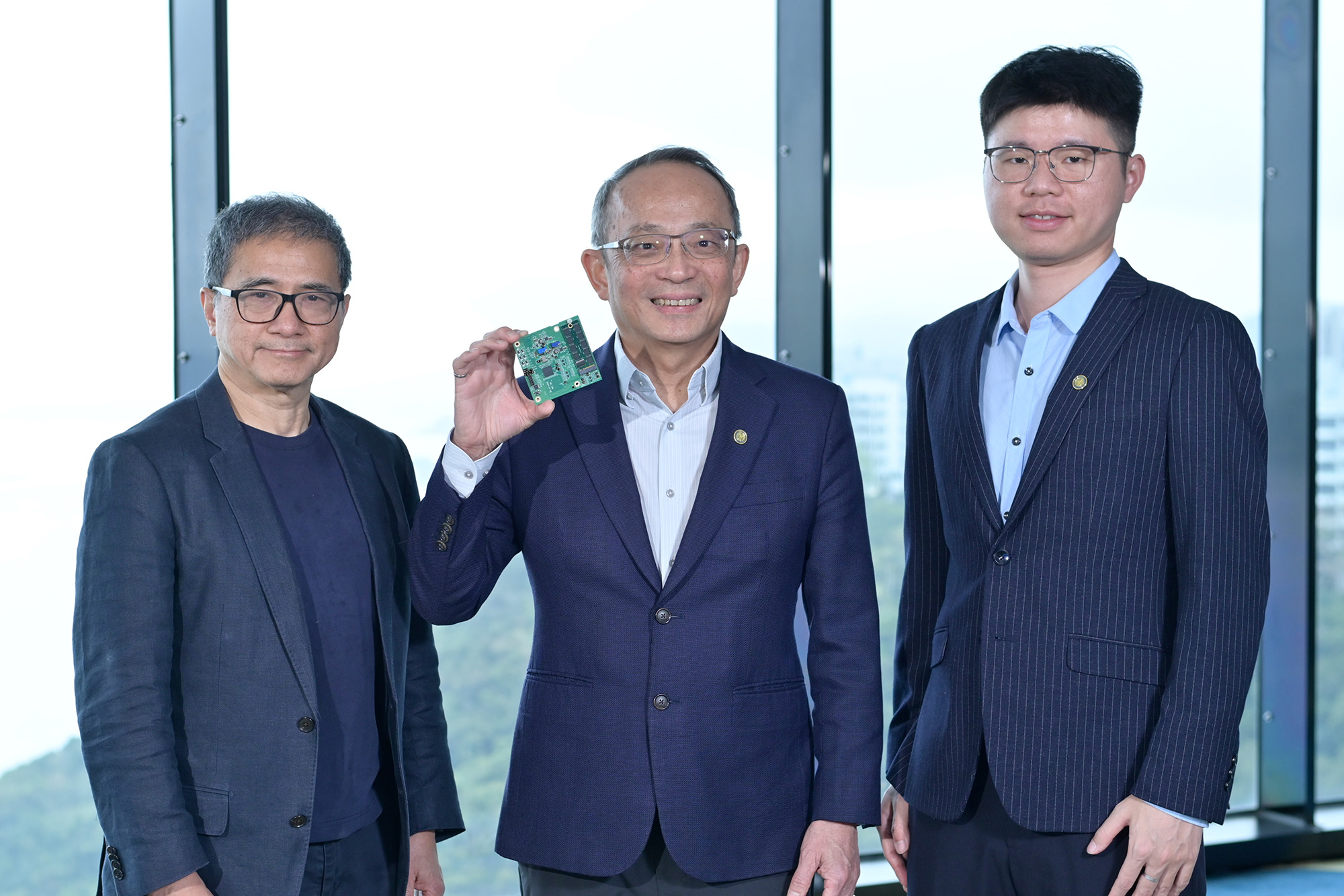

基于这些创新点,ACCESS 团队设计并且成功流片了 28nm 的商业化实验芯片 AC-Transformer,实现了可编程的 CNN 和 Transformer 模型的端到端推理。AC-Transformer 芯片在 SegFormerB0 上每个令牌消耗 0.22μJ,与之前报道的最新成果相比,实现了 3.86-10.91 倍的系统级能效提升。

ACCESS 团队的此项研究成果在国际学术界获得高度认可,是所有参与项目的教授、研究生、研究员和工程师的辛勤付出的结果,也是协同创新共同推动 AI 计算架构前沿探索成功范例。ACCESS 研发团队将继续深耕智能计算技术,探索更高效、更先进的 AI 芯片架构,为行业发展贡献更多创新成果。